Los investigadores han comenzado a desentrañar el mayor enigma de la ciencia

Diferentes líneas de investigación en todo el mundo trabajan actualmente para entender y recrear el origen de la vida. Los orígenes pudieron ser varios, incluyendo el espacio extraterrestre, señaló Carlos Briones, investigador del Centro de Astrobiología (CAB) de Madrid, en la tercera conferencia del ciclo virtual «Explorando los límites del espacio», organizado este año por el Museo Nacional de Ciencia y Tecnología (MUNCYT).

El doctor en bioquímica y biología molecular indicó que se entiende como origen de la vida aquel momento en que las moléculas químicas pasaron a formar parte de entidades capaces de replicarse, dando lugar a la primera célula antecesora de todos los seres vivos. Si alrededor de 350 millones de años fueron suficientes para este salto, significaría que la vida surge, con cierto determinismo, cuando las condiciones lo permiten. Si no fueron suficientes años, la vida, o parte de sus moléculas, tendrían su origen fuera de la Tierra y llegarían a bordo de meteoritos. “Esto es una pregunta científica de mucho calado en la actualidad”, apuntó Briones.

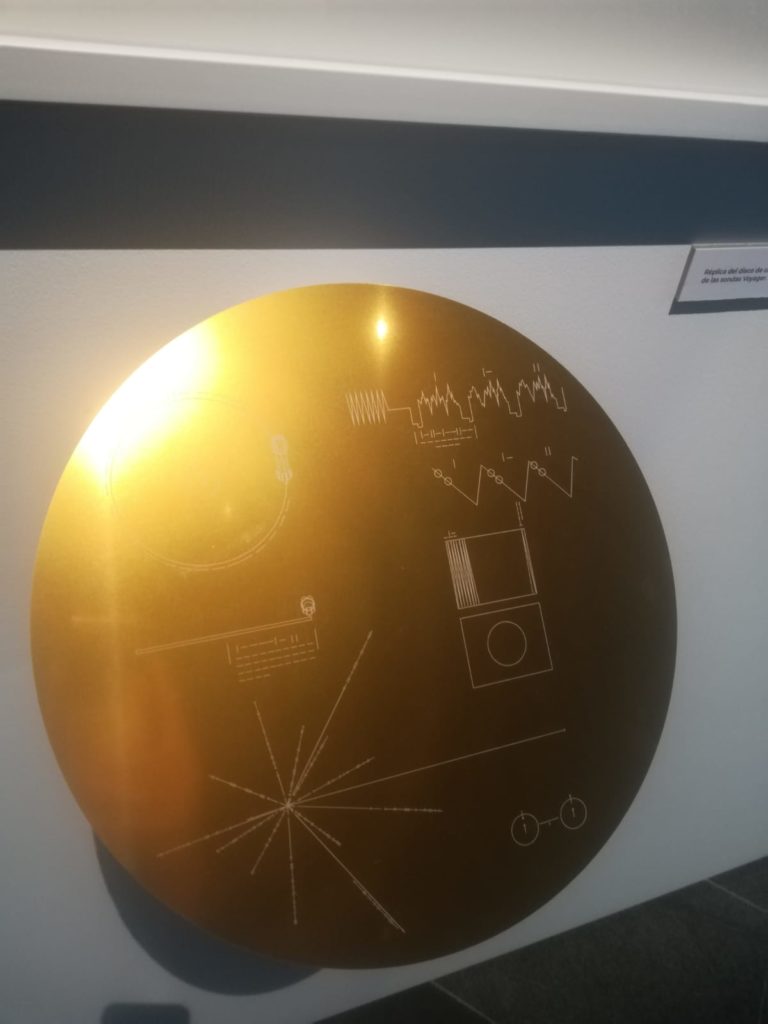

Desde el comienzo de los tiempos el ser humano se ha preguntado cuál es el origen de la vida y si existe en otros planetas. Saber si estamos solos en el universo ha sido una de las grandes cuestiones de todos los tiempos. En los últimos años, surge una nueva ciencia para estudiar y responder estas cuestiones, la astrobiología.

Pero para lanzarnos a buscar vida en otros planetas tenemos que saber qué es la vida. “Encontraremos lo que busquemos”, remarcó el investigador. El nuevo vehículo motorizado de la NASA, el Mars rover Perseverance, está iniciando una misión en Marte que permitirá detectar morfologías compatibles con la vida. No obstante, “no todo lo que tiene forma de ser vivo tiene por qué ser un ser vivo, la morfología no es criterio suficiente”, advirtió. Por ejemplo, a partir de material inorgánico, como carbonatos o silicatos, ya se pueden sintetizar en el laboratorio estructuras químicas similares a los seres vivos en cuanto a forma, pero son inertes.

Briones indicó cuáles son los elementos fundamentales que debemos buscar para detectar vida fuera de la Tierra. Existen moléculas orgánicas que sólo pueden producirse por los organismos vivos y no son posibles desde el punto de vista de la química al margen de la vida, con un origen geoquímico, por ejemplo. Son los llamados biomarcadores, como el colesterol o el ADN. “Es lo que nos interesaría detectar en otros planetas cuando nos preguntamos si allí surgió la vida”. Señaló, además, que el agua se asume como un prerrequisito y es lo primero a tener en cuenta y que el carbono es el elemento con mayor facilidad para formar enlaces con otros átomos y construir las moléculas complejas que requiere la vida. “Se conocen más de 17 millones de compuestos orgánicos basados en carbono”, matizó.

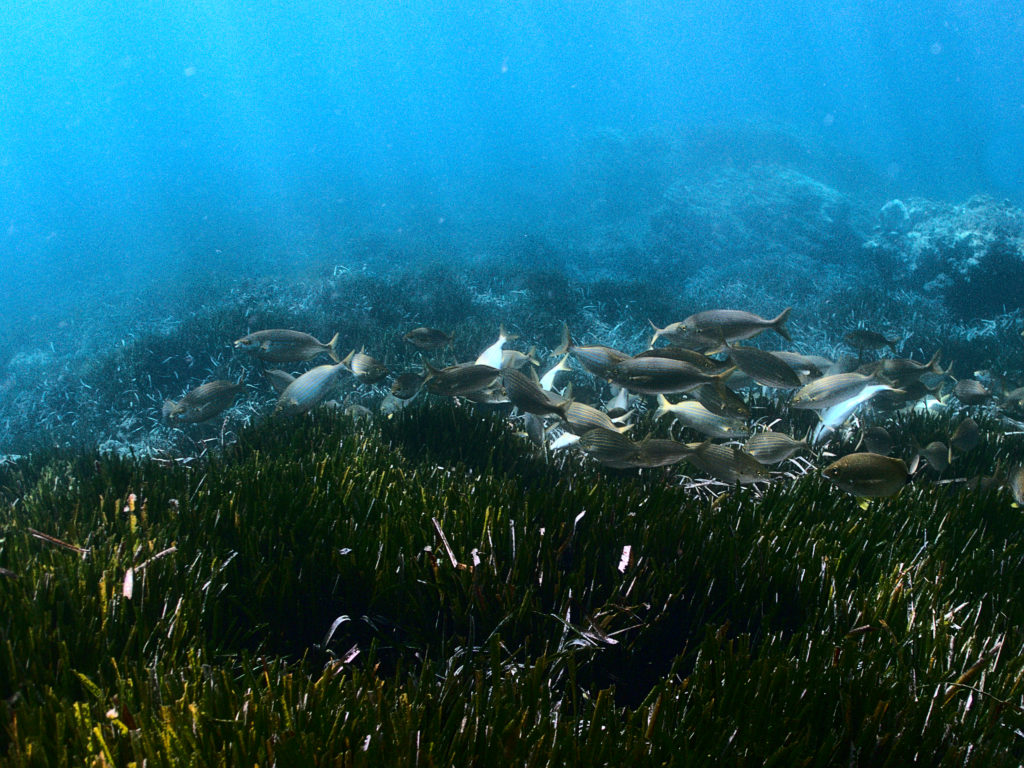

Presentó otra cuestión que, según señaló, “no se debe olvidar” y es que solo el 15% de las especies conocidas en la Tierra son organismos pluricelulares. “Nuestro punto azul pálido es un planeta de microorganismos. Son los reyes del planeta”, mencionó. Esto apunta a que los microorganismos como las bacterias son los candidatos perfectos para aparecer en el espacio.

El experto definió los seres vivos como las entidades que cumplen tres cosas: tienen moléculas que contienen información genética que pueden pasar a la descendencia, tienen compartimentos que permiten su separación del entorno y tienen un metabolismo que les permite intercambiar materia y energía con el medio. Y aclaró: “Muchos científicos consideramos que los virus no son seres vivos porque no tienen metabolismo propio”.

Además de saber qué son los seres vivos, conocer cómo se originaron es también importante para su búsqueda. Briones explicó que la ciencia utiliza dos aproximaciones para obtener conocimientos a este respecto. El enfoque bottom-up (o del pasado hacia el presente), que se dota de la astroquímica y la química que existía antes de los seres vivos, prebiótica, y el enfoque top-down (o del presente hacia el pasado), que se centra en el estudio de la biodiversidad actual y la evolución para acercarse al origen de la vida en retrospectiva.