ENTREVISTA | Antonio Diéguez Filósofo de la biología

Antonio Diéguez es Catedrático de Lógica y Filosofía de la Ciencia en la Universidad de Málaga. Su dilatada y laureada trayectoria académica comenzó con el realismo científico, un debate clásico de la filosofía de la ciencia del que es un exponente nacional. Cuando los puntos clave de los análisis filosóficos sobre ciencia quedaron acotados los filósofos se especializaron en ciencias concretas. Él escogió la biología, lo que le permitió explorar un terreno en el que se muestra muy cómodo: las fronteras entre la naturalezade los diferentes seres vivos. Su debate más reciente trata sobre la existencia de un límite verdadero entre lo que entendemos como animales, humanos e hipotéticos seres transhumanos. Comprometido con la divulgación, es autor y coordinador de numerosas publicaciones y un conferenciante experimentado. Un hombre con múltiples talentos que ha sabido cambiar de opinión en el momento acertado.

Usted es un referente del realismo científico y autor de un libro homónimo ¿Cómo definiría esta corriente?

El realismo científico es una posición dentro de la filosofía de la ciencia que defiende tres cosas: existe una realidad, las teorías científicas proporcionan conocimiento sobre ella y la ciencia progresa hacia teorías más verdaderas. También tiene conexiones fuertes con debates de historia de la ciencia y con el realismo filosófico.

¿Qué le llevó a interesarse por el realismo científico?

A raíz de mi tesis doctoral leí a J.S. Mill, Karl Popper y Thomas Kuhn. Después empecé a explorar de manera sistemática a todos los filósofos de la ciencia importantes. Además de los autores citados, leí obras de Whewell del siglo XIX y me interesé por el Círculo de Viena e Imre Lakatos, hasta llegar a nuestros días. De los recientes, me impactó fundamentalmente la lectura de un filósofo finlandés con el que luego tuve una buena relación personal, Ilkka Niiniluoto. Fue rector de la universidad de Helsinki durante varios años y está considerado como uno de los grandes teóricos del realismo científico. Ilkka escribe de forma muy clara y su visión de este asunto era muy convincente, así que empecé a escribir un libro al respecto.

Realizó varias estancias en el departamento de Filosofía de la Ciencia de la Universidad de Helsinki.

Sí, fui para debatir sobre los temas del realismo científico con Ilkka Niniiluoto. Es uno de los departamentos de filosofía de la ciencia más prestigiosos del mundo. Tuvo entre sus primeros miembros a un integrante del círculo de Viena, Eino Kaila. El director más querido y más influyente que ha tenido es Georg Henrik von Wright, discípulo y albacea testamentario de Wittgenstein. Yo lo conocí la primera vez que fui, era un hombre impresionante. También ha tenido figuras tan prestigiosas como Jaakko Hintikka o el propio Niniiluoto. La verdad es que estuve muy a gusto en el departamento. Fue un lujo estar con expertos cuyo su trabajo ha tenido una gran influencia en la filosofía de la ciencia del siglo XX, trabajar en aquel ambiente y aprovechar los recursos bibliográficos que se me ofrecían.

“Necesito cambiar de tema cada 10 años”

Antonio Diéguez

¿Siempre ha sido simpatizante del realismo científico?

Cuando empecé a escribir el libro, al igual que la mayoría de jóvenes filósofos, era un antirrealista. Las posiciones realistas, no sé por qué, eran y son consideradas como más conservadoras. Lo digo porque el marxismo clásico defendía claramente el realismo. Marx, Lenin y Engels eran realistas. El libro de Lenin “Materialismo y empirocriticismo” es una defensa del realismo frente al fenomenismo y al positivismo previo al siglo XX. Cuando empecé con el libro, pese a que mis simpatías estaban con las posiciones antirrealistas, me fui dando cuenta de que los argumentos del realismo eran muy buenos. Me fueron convenciendo poco a poco, de manera que acabé el libro siendo realista. Desde entonces conservo la misma convicción, quizás no tan fuerte como entonces, pero en general sigo pensando que es la mejor manera de interpretar la ciencia y las teorías científicas. Lo cual no significa que eventualmente surjan teorías que puedan ser meros instrumentos de cálculo o herramientas para producir tecnología, pero ese no es el objetivo principal de la ciencia. El objetivo principal de la ciencia, aunque a muchos científicos les suene trasnochado, es descubrir la verdad sobre el universo.

Ha mostrado ser capaz de cambiar de opinión. ¿Tuvo claro desde el principio que quería dedicarse a la filosofía?

Nací en Málaga, en un barrio obrero de trabajadores, y no tenía en aquel momento ninguna idea de lo que era la filosofía ni que iba a ser mi vocación. Al principio me interesaba la pintura, me hubiera gustado ser pintor pero no pudo ser. Hace mucho que no pinto, más de 10 años, pero no descarto volver a pintar alguna vez. Aún me arrepiento de ello. En realidad no tenía vocación filosófica, decidí estudiar filosofía en la cola de matriculación. Quien me influyó en el último instante para hacer filosofía en lugar de otra carrera de humanidades fue un buen amigo que estaba interesado en ella. Yo, con gusto, había podido leer un par de libros de Nietzsche, como “Así habló Zaratrustra”. Fue una decisión muy poco informada, fue un poco al azar. Por eso digo a las personas preocupadas por su futuro que tomen una decisión. Que la vocación muchas veces va surgiendo. Cuando empecé la carrera me di cuenta de que era un buen camino para seguir y tener una profesión.

Parece que la decisión fue acertada, fue reconocido con el Premio Extraordinario de Licenciatura. También obtuvo el Premio Extraordinario de Doctorado por su tesis sobre John Stuart Mill.

Empecé con J.S. Mill gracias a la llegada a Málaga de mi director de tesis, el profesor Pascual Martínez Freire, gran catedrático de lógica y filosofía de la ciencia. Él no podía dirigir una tesis de ética como me hubiera gustado, pero llegamos a un pequeño acuerdo: podría escoger un autor que tuviera relevancia en ética y política pero tendría que analizarlo desde la perspectiva de la filosofía de la ciencia. Su orientación y su ayuda fue fundamental. El indicado era Mill porque tenía una teoría pionera sobre la metodología de las ciencias sociales que estaba poco estudiada. La desarrollaba al final de su libro «Un sistema de lógica», que tuvo una gran influencia a finales del XIX y principios del XX. Lo que hice en la tesis fue trazar la historia del pensamiento metodológico en las ciencias sociales hasta la aportación de Mill, además de su influencia posterior.

¿Qué aspectos le llamaron la atención de la obra de J.S. Mill? ¿Comparte su definición de etología, que la sitúa como “la ciencia del carácter humano en el sentido más amplio del término”?

Mill dominaba el lenguaje. De su obra me atrajeron dos cualidades: su estilo claro preciso y su elegancia a la hora de exponer y defender las ideas. Fue una escuela de escritura que creo ha influido en mi propio estilo. Su idea de la etología sin embargo me parece que no era muy acertada. En cambio, hizo aportaciones muy interesantes. Mill pensaba que el método de las ciencias sociales tenía que ser lo que luego hemos llamado método hipotético-deductivo. Está considerado uno de los padres del inductivismo, la idea de que los descubrimientos científicos se obtienen mediante inducción, que luego rechazó Popper por completo. Sin embargo, para las ciencias sociales deja abierta una metodología diferente en la que tiene más importancia la invención de hipótesis y el uso de la deducción. Así que en ese sentido, Mill se adelantó un poco a su época.

Tras explorar debates de filosofía de la ciencia como este se especializó en filosofía de la biología.

Yo necesito cambiar de tema cada 10 años. No quería seguir leyendo sobre el realismo porque, aunque seguía siendo un debate intenso en el que surgían nuevas corrientes, me parecía que los grandes argumentos y las ideas centrales estaban ya expuestas. Quizás me equivoqué, porque el debate sigue y han surgido propuestas muy interesantes. Por otro lado, en torno al cambio del siglo XX al XXI, ya era evidente que la filosofía general de la ciencia no era un campo que fuera a dar resultados comparables a los que había dado previamente. Quien quisiera escribir algo sobre la ciencia desde un punto de vista filosófico tenía que especializarse en una ciencia y hablar con un conocimiento cercano. A finales de los 90 casi todos los filósofos de la ciencia empezaron a trabajar en alguna ciencia concreta, fue una cuestión generacional. La filosofía de la ciencia tradicional se había centrado sobre todo en la física, pero en ese momento había otras disciplinas científicas emergentes, como la biología o la economía.

Antonio Diéguez en una ponencia sobre el transhumanismo.

Usted, además, cursó parte de la licenciatura de biología.

Hay que conocer la disciplina de primera mano, por ello me matriculé, cursé y aprobé hasta final del tercer curso. En ese momento era vicedecano y tenía que pasar muchas horas en el despacho. Yo no iba a ejercer de biólogo y las prácticas de los últimos cursos ocupaban tardes enteras, así que decidí dejarlo porque ya conocía la teoría y los rudimentos de la práctica. La biología es una ciencia fascinante porque muestra que se puede hacer una ciencia de máximo rigor con unas aplicaciones prácticas increíbles utilizando una metodología muy diferente a la de otras ciencias. Cuando se habla del Método Científico con mayúsculas y en singular, pienso que es más una abstracción de cara a la galería, que otra cosa. En la realidad lo que vemos son ciencias diversas con metodologías diversas. La que sigue un físico de partículas tiene muy poco que ver con la que sigue un bioquímico, un paleontólogo, un ingeniero químico o un etólogo. Sin embargo, todos son métodos científicos. Si se interpreta correctamente la afirmación de Feyerabend de que “en la ciencia todo vale” (cosa que no siempre se hace), entenderemos que tenía bastante razón. Lo que Feyerabend quería decir es que si nos empeñamos en buscar un precepto metodológico universal para todas las ciencias, éste tendría que ser algo así como “todo vale”, lo que es tanto como decir que, en realidad, no hay ningún precepto universal sino una enorme diversidad de métodos. Lo que no está diciendo Feyerabend es que literalmente pueda hacerse pasar cualquier cosa por científica. La pluralidad de métodos hace que se rechacen también muchas propuestas en la ciencia por no ser aceptables desde algún criterio metodológico aceptado. Las ciencias son muy diversas, no hay una metodología única. Eso es lo que la biología ha mostrado sin lugar a dudas. Todas las disciplinas de la biología, con mayor o menor rigor y matematización, han mostrado que se puede hacer una ciencia sin nada que envidiarle a la física. Ambas son ciencia, pero distintas metodológicamente. En biología, en lugar de leyes, existen modelos matemáticos. No son lo mismo pero ambos sirven para explicar y predecir fenómenos. Esto es un cambio de perspectiva fundamental en la filosofía de la ciencia porque muestra una de las limitaciones de lo que habían dicho miembros del Círculo de Viena sobre cómo funciona la ciencia. La biología es un buen ejemplo de cómo la ciencia es plural, de cómo los métodos se aplican de formas muy diferentes según el campo. Esto era muy interesante desde el punto de vista filosófico y fue una de las razones por las que decidí estudiar biología. Pero también, indudablemente, porque ya empezaba a estar claro el impacto que iba a tener la ingeniería genética y la biotecnología.

La filosofía de la biología enfrenta grandes debates actualmente. Usted ha participado en la publicación de Naturaleza animal y humana con el capítulo “Pensamiento conceptual en animales”.

Uno de los problemas que tienen algunos filósofos de educación tradicionalista es seguir anclados en la idea de que el pensamiento es tan complejo que requiere de un lenguaje también complejo. Creen que cuando hablamos de “conceptos” estamos captando la esencia de algo que no se puede captar sin una inteligencia abstracta, muy sofisticada. Si uno lee los trabajos de los primatólogos sobre la cognición en primates en los últimos veinte años, no puede seguir manteniendo una concepción tan tradicionalista de lo que es la mente. Conviene mencionar a Frans de Waal y Josep Call, discípulo catalán de Michael Tomasello. Yo les digo a mis alumnos que no sigan definiendo al ser humano como el animal racional, porque no es una buena definición. Los grandes simios y otros primates son capaces de hacer inferencias transitivas, disyuntivas, etc. Por tanto, son racionales, aunque no posean un lenguaje. Acepto que es una noción muy básica de racionalidad, pero me parece válida. Por tanto, definamos mejor al ser humano, si uno quiere, con la otra traducción posible de la frase de Aristóteles. Aristóteles dijo que el ser humano era Zoon logon echon, el animal que tiene logos. Logos también se puede traducir como palabra. El hombre es, por tanto, el animal con lenguaje. Existen animales que pueden aprender un lenguaje, como el bonobo Kanzi, la gorila Koko o el loro Alex, pero no es un lenguaje propio, y, en todo caso, se discute si pueden manejar bien la sintaxis.. Las diferencias entre los seres humanos y otros animales, particularmente otros primates, son de grado. No se trata de un abismo ontológico.

“Hay que estar abierto a la aplicación de la biotecnología en el ser humano”

Antonio Diéguez

Otra cuestión alrededor de la naturaleza del ser humano es el transhumanismo, sobre el que escribió un libro.

En 2015 hice una estancia de investigación en Oxford en la que trabajé sobre el transhumanismo. Estuve en el centro Uehiro para la Ética Práctica, uno de los lugares principales del pensamiento transhumanista en este momento. Es un movimiento filosófico, cultural, con ribetes incluso religiosos, que pretende mejorar al ser humano por medio de la tecnología. En concreto con las tecnologías más avanzadas, que en este momento son la inteligencia artificial y la biotecnología. Los transhumanistas creen que el ser humano no es un ser acabado, que no existe una naturaleza humana estable, sacrosanta, que sea absolutamente inmoral tocar o modificar. Piensan, en cambio, que el ser humano es un ser cambiante que tiene mucho todavía que hacer para mejorar. Como esta mejora a través de la cultura es muy lenta, por no decir ineficaz, apoyan la idea de mejorar la especie mediante la tecnología o la unión con la máquina. Creo que el discurso transhumanista es digno de atención, está soportado por muy buenos argumentos y autores. Hay que atender a expertos como Julian Savulescu o Nick Bostrom y estar abierto a la aplicación crítica y prudente de las nuevas tecnologías, como la biotecnología, al ser humano.

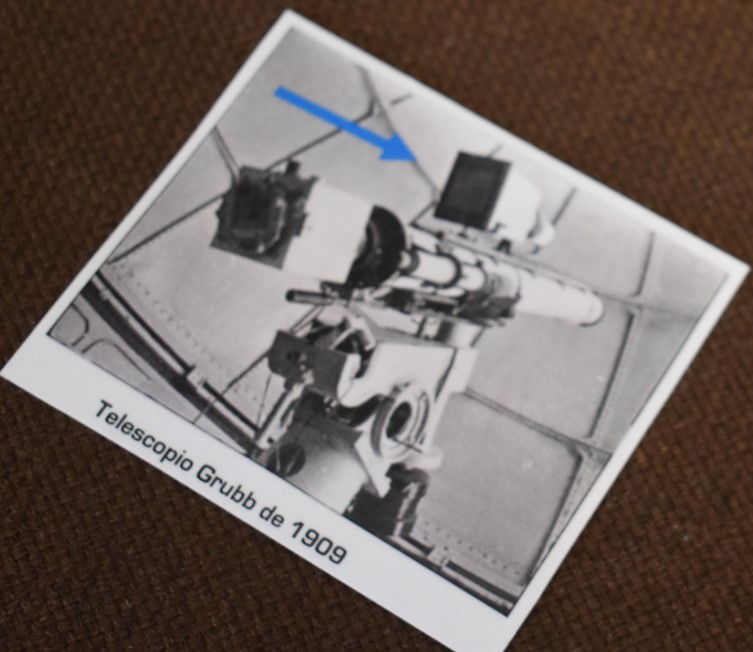

También realizó una estancia en Harvard.

Harvard es una universidad impresionante, siempre está entre las cinco mejores del mundo. Es la investigación en estado puro. El conglomerado de las ciudades de Cambridge y Boston, donde se encuentra además el MIT y otras universidades de enorme prestigio, es la zona del mundo con más premios Nobel por kilómetro cuadrado. Eso crea un clima intelectual asombroso. Tenía por costumbre asistir todas las semanas a alguna conferencia, ya que siempre las impartían figuras mundiales. Fue un lujo poder asistir al seminario que impartía Peter Godfrey-Smith, filósofo de la mente, junto con el biólogo David Haig. Asistió como oyente nada menos que el afamado filósofo Daniel Dennett y mantuvieron conversaciones muy interesantes. Percibí también una mentalidad diferente a la nuestra en los alumnos. Allí el alumno es incitado a no temer equivocarse, siempre que sepa defender bien su posición. Dan más importancia a la capacidad de argumentar las ideas propias que al hecho de que sean acertadas o equivocadas.

¿Cuál es el valor más destacado de las estancias en otras universidades?

Creo que son la mejor parte de la carrera profesional. A los profesores en España desgraciadamente nos tienen atados con demasiadas horas de clase -estamos mal financiados para eso también- y no nos dejan ir al extranjero tanto como nos gustaría. Sin embargo, es algo que luego nos piden en el CV

Muchos profesores e investigadores son también divulgadores. ¿Cuál cree que es el papel de la comunicación de la ciencia en la sociedad actual?

La comunicación de las ciencias debería tener un papel central, la ciencia necesita estar en contacto con el público. No comunicar los resultados despierta recelos. Las actitudes anticientíficas coinciden en un rechazo a la ortodoxia y en pensar que hay intereses oscuros o que la investigación está sesgada. Que tanta gente piense de ese modo es una desgracia y es peligroso. La ciencia ha de preocuparse por su imagen pública. No puede ser que a un científico le cueste perder prestigio el hecho de dedicar parte de su tiempo a la divulgación. Es central para la supervivencia de la propia ciencia y es absurdo que las publicaciones de este tipo no tengan prácticamente ningún valor curricular. Existe una idea cientifista de que el auténtico científico se dedica a otras tareas más serias, que esa es una tarea menor. No lo es; al igual que no lo es el tema de la financiación, que todos los equipos de científicos entienden. La ciudadanía tiene que percibir que incluso la investigación básica es útil. Creo que se está empezando a entender, pero ha costado.